Comment fonctionne un ordinateur quantique ?

Date:

Mis à jour le 02/08/2022

Avant d’expliquer la différence entre ordinateur classique et ordinateur quantique, il est nécessaire de comprendre deux concepts de physique quantique :

Les ordinateurs classiques ou conventionnels sont programmés avec des bits comme unités de données. Chaque bit peut stocker un 0 ou un 1. Pourtant, ces ordinateurs sont mis face à leurs propres limites lorsqu’ils se retrouvent confrontés à un problème de variables multiples. Dans ce cas, les ordinateurs doivent effectuer un nouveau calcul chaque fois qu'une variable est modifiée. Chaque calcul est un chemin unique vers un résultat unique.

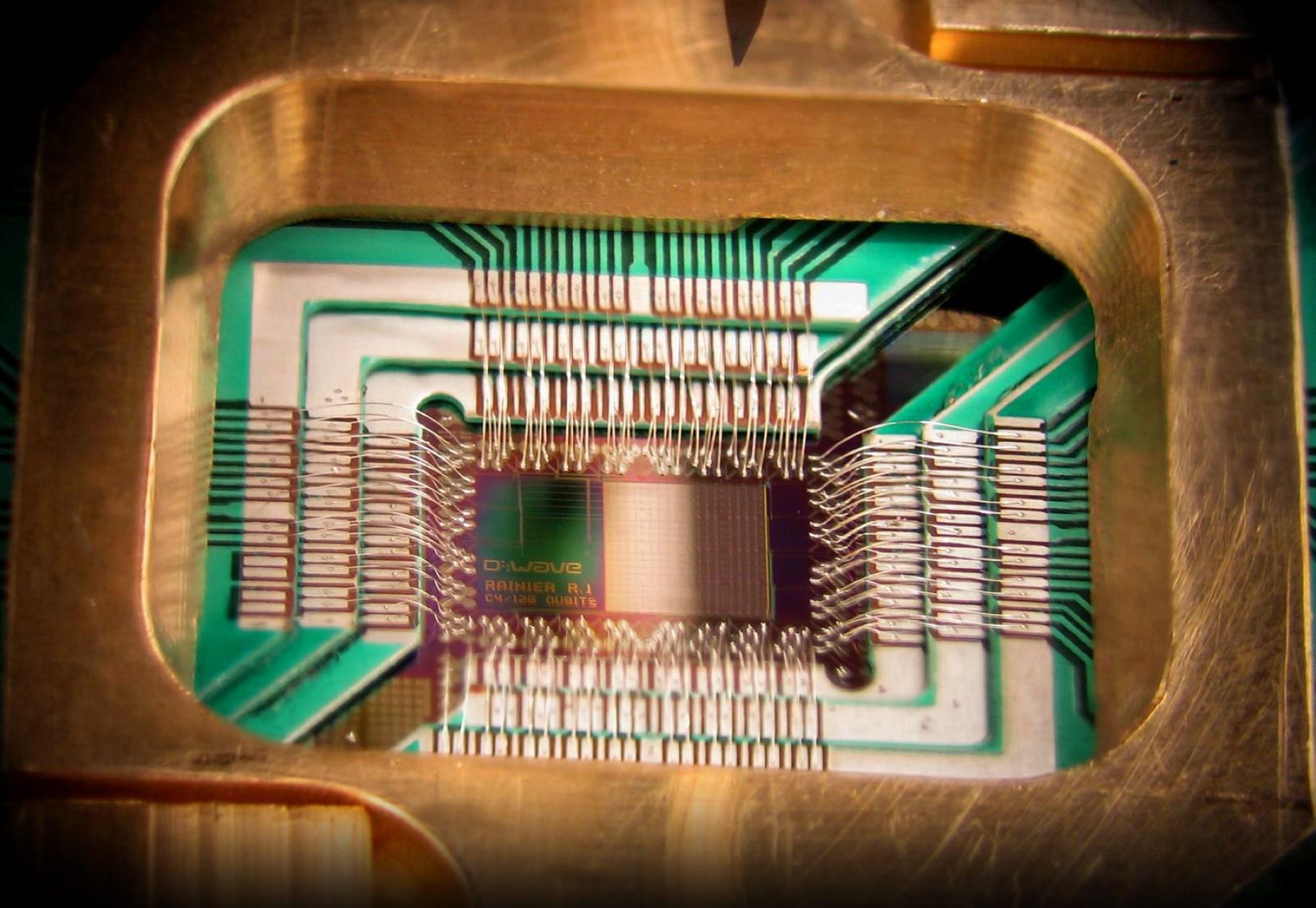

L’ordinateur quantique, lui, se base sur les concepts expliqués ci-dessus. En raison des lois de la mécanique quantique, celui-ci utilise des qubits, qui peuvent représenter une combinaison de 0 et de 1 en même temps, selon le principe de superposition. Chaque qubit existe ainsi en multiple états de 0 et 1, simultanément. L’ordinateur quantique va ainsi exploiter l'intrication entre les qubits et les probabilités associées aux superpositions pour effectuer une série d'opérations, de telle sorte que certaines probabilités soient augmentées (c'est-à-dire celles des bonnes réponses) et d'autres diminuées, voire nulles (c'est-à-dire celles des mauvaises réponses).

C’est cette possibilité d’emprunter un nombre gigantesque de chemins qui rend les ordinateurs quantiques bien plus rapides que les ordinateurs classiques. Les ordinateurs quantiques ne remplaceront pas les systèmes actuels, mais seront utilisés pour différents types de problèmes, incroyablement complexes, dans lesquels l'élimination d'un large éventail de possibilités permettra de gagner énormément de temps.

Un exemple souvent cité est l'exécution de certains algorithmes, bien plus rapidement, qui pourrait notamment permettre de factoriser en nombres premiers, de résoudre le "problème du voyageur" (optimisation de chemins), de rechercher dans des bases de données, ou encore de simuler des équations différentielles complexes.

Un ordinateur quantique pourrait également permettre d’inventer des molécules, de simuler de nouveaux matériaux, de résoudre des problématiques liées à la logistique ou encore de simuler de manière exacte des réactions chimiques qui nous paraissent encore mystérieuses.

Les problématiques qui pourraient être résolues grâce au quantique ne sont aujourd’hui pas toutes connues. C’est, entre autres, ce sur quoi les acteurs de la recherche travaillent aujourd’hui.

Mais avant de pouvoir profiter du potentiel de l’ordinateur quantique, de nombreux verrous doivent encore être levés afin que celui-ci puisse déjà voir le jour.

La décohérence en est l’obstacle majeur : l’ordinateur quantique, pour calculer de manière bien plus rapide et efficace qu’un ordinateur classique, va utiliser la superposition et l'intrication d'états qui sont beaucoup plus sensibles à l'environnement que les états classiques. Plus on va ajouter de qubits à un système, plus la quantité d’opérations parallèles va être augmentée et, par conséquent, la puissance de calcul également. On estime ainsi que près de 300 qubits parfaitement enchevêtrés en superposition pourraient cartographier toutes les informations de l'univers à partir du Big Bang.

Pourtant, lorsque l'environnement interagit avec les qubits (ce qui est nécessaire pour que la mesure quantique fonctionne), celui-ci va changer de manière incontrôlable leurs états quantiques. C’est ce qu’on appelle la décohérence. Celle-ci peut provenir de nombreux aspects de l'environnement : modifications des champs magnétiques et électriques, rayonnement d'objets chauds à proximité ou interactions non contrôlées entre les qubits.

La décohérence affecte l'état de superposition et perturbe le traitement quantique de l'information. Cela conduit à des erreurs dans les systèmes de calcul quantique. Alors qu’un ordinateur classique se révèle très fiable, un ordinateur quantique ferait une erreur sur 1 000 opérations (pour les meilleurs d’entre eux).

Verbatim

L’information dans un ordinateur est sans arrêt contaminée par des erreurs, explique le chercheur. Or dans le monde quantique, mesurer ces erreurs est extrêmement difficile car la mesure influence le paramètre !

Auteur

Poste

chercheur au sein de l’équipe-projet Quantic (Inria Paris)

Alors, comment faire tomber ces verrous ? Pour voir un ordinateur quantique réussir à exécuter des calculs viables et ainsi, révolutionner bon nombre de domaines, il faudrait ainsi fabriquer, contrôler et mesurer plusieurs qubits, réaliser des portes quantiques, et enfin développer des algorithmes qui profiteraient de l’accélération quantique.

Il existe en effet une limite à la durée pendant laquelle les qubits peuvent conserver leurs propriétés quantiques avant que des erreurs ne viennent perturber le mécanisme de calcul. C'est ce qu'on appelle la longueur de cohérence. Pour réduire le risque d’erreurs dans les calculs réalisés par un ordinateur quantique, il faudrait ainsi avoir des qubits avec une longueur de cohérence suffisamment longue pour calculer des problèmes mathématiques.

Et pour augmenter cette longueur de cohérence, des chercheurs travaillent aujourd’hui au développement d’algorithmes de réduction d'erreurs en utilisant un code correcteur d’erreurs quantiques (le premier ayant été développé par Peter Shor). Cela leur permet notamment d’encoder un qubit logique dans plusieurs qubits physiques, de sorte que les erreurs deviennent tractables. On doit pouvoir également effectuer des portes logiques, afin d’améliorer la performance des opérations.

Quoi qu’il en soit, il faudrait des centaines de millions de qubits connectés de manière cohérente pour avoir un ordinateur quantique universel. Les quelques machines quantiques qui existent aujourd’hui ne peuvent, pour le moment, pas supporter de gérer autant de qubits qu’il serait nécessaire pour passer à l’échelle. « Au vu des informations disponibles, il est encore trop tôt pour prédire à quel horizon un ordinateur quantique de taille suffisante pourra exister », expliquait The National Academies of Sciences, Engineering, and Medicine en 2019, dans un rapport intitulé Quantum Computing : Progress and Prospects.

En attendant, en France, l’écosystème quantique tend à se structurer : scientifiques, industriels, startups, ou encore décideurs politiques se sont déjà lancés dans la course à l’accélération quantique, en travaillant notamment sur le déploiement d’infrastructures quantiques, mais aussi sur ce qui permettra d’exploiter et de développer les possibilités offertes par les architectures matérielles.