Algorithmes d'apprentissage : les bandits manchots au cœur d’une équipe associée franco-japonaise

Date:

Mis à jour le 10/02/2025

« En tant que chercheurs et chercheuses académiques, nous avons la chance de pouvoir créer les fondements théoriques qui permettront de relever des enjeux de société à la racine des industries de demain », s’enthousiasme Odalric-Ambrym Maillard, chargé de recherche Inria et coordinateur de l’équipe associée Reliant en France. L’apprentissage par renforcement fait partie de ces sujets cruciaux, et est au centre des travaux de Reliant. Pendant trois ans, des scientifiques de l’équipe-projet Scool (commune au Centre Inria de l’Université de Lille et au laboratoire CRIStAL) et de l’université de Kyoto, au Japon, ont travaillé sur ce sujet - et plus spécifiquement sur les "bandits manchots".

Cette théorie, qui permet de produire des algorithmes prédictifs, est confrontée à un défi de taille : l’écart entre ses résultats théoriques et ceux issus de la mise en pratique sur des cas concrets. « Notre volonté a donc été de confronter nos algorithmes au monde réel, afin de lever les freins à leurs applications », résume le chercheur.

L’équipe de Junya Honda, professeur associé à l’université de Kyoto, est elle aussi à l’avant-garde de la recherche fondamentale sur l’apprentissage par renforcement. « Nous avions en commun cette envie d’appliquer nos travaux théoriques dans le monde réel, plutôt que sur des simulateurs, explique-t-il. En 2019, j’ai donc invité Odalric-Ambrym Maillard à une conférence sur l’actualité des bandits manchots. » À cette occasion, les deux chercheurs nouent des liens, avec la perspective d’un projet de collaboration. C’est ainsi qu’émerge l’idée de l’équipe associée Reliant.

Le terme de "bandits manchots" fait référence aux machines à sous. Dans le domaine des probabilités, il s’agit d’un problème d’optimisation : face à plusieurs machines, on souhaite déterminer laquelle est la plus rentable. La méthode pour y parvenir repose sur un équilibre entre exploration et exploitation : d’abord, on teste plusieurs machines pour découvrir celles qui rapportent le plus, puis on optimise les gains à partir des connaissances acquises.

Il s’agit d’un cas simplifié d’apprentissage par renforcement, où un "agent" apprend à prendre des décisions en essayant différentes actions, et en observant ce qui se passe. Chaque action entraîne une récompense indiquant si l’agent a bien agi ou non. Il ajuste progressivement sa stratégie pour choisir les actions qui lui rapportent le plus sur le long terme. L’objectif est de minimiser le "regret", soit l’écart entre la récompense obtenue et celle qu’aurait apportée le choix de la meilleure option à chaque étape.

Les algorithmes ainsi conçus peuvent aider à la prise de décisions dans de nombreuses situations. « En médecine, cette méthode est particulièrement bien indiquée, estime Odalric-Ambrym Maillard. Mais dans ce contexte, il n’existe pas de simulateur humain pour entrainer les algorithmes. Il nous faut donc confronter la théorie avec la réalité médicale. » Prenons l’exemple d’un projet mené avec l’hôpital de Lille, où un suivi postopératoire implique des prises de décision pour les patientes et patients : à quel moment leur demande-t-on de revenir en consultation ? Quel spécialiste doivent-elles ou doivent-ils rencontrer ?

Ces questionnements, dans le cadre de l’apprentissage par renforcement, sont confrontés à différentes difficultés : des échantillons de très petite taille (ici, le nombre de patientes et patients), une "aversion au risque" (la volonté d’éviter un impact négatif), mais aussi des situations dites "non paramétriques", le respect de la vie privée, ou encore la corruption des données. L’équipe associée Reliant a démontré comment optimiser des algorithmes malgré ces contraintes, ce qui n’avait encore jamais été fait.

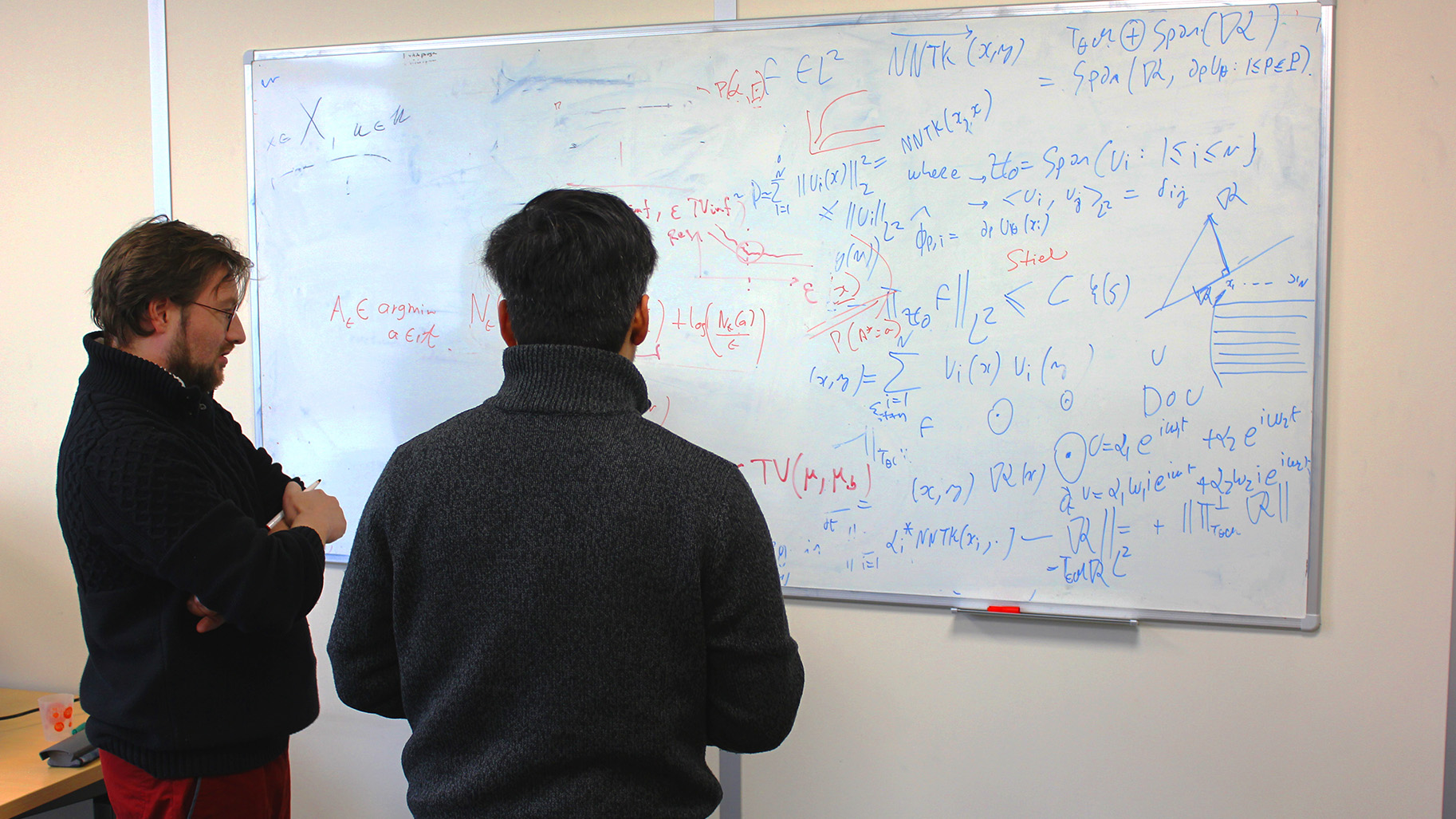

Image

Verbatim

L’une des grandes difficultés est l’écart entre la théorie et le comportement réel des algorithmes avec très peu de données, comme c’est le cas en médecine. Notre équipe a donc cherché à déterminer la solution avec la meilleure garantie d’exactitude dans le cadre d’un nombre limité d’essais.

Auteur

Poste

Professeur associé à l’université de Kyoto

Côté Inria, les scientifiques se sont penchés sur les cas non paramétriques, c’est-à-dire lorsqu’il est impossible de modéliser l'ensemble des paramètres en jeu. « Notre cas d’étude était l’agroécologie, décrit Odalric-Ambrym Maillard. L’objectif : déterminer les meilleures pratiques agricoles parmi une dizaine de stratégies. »

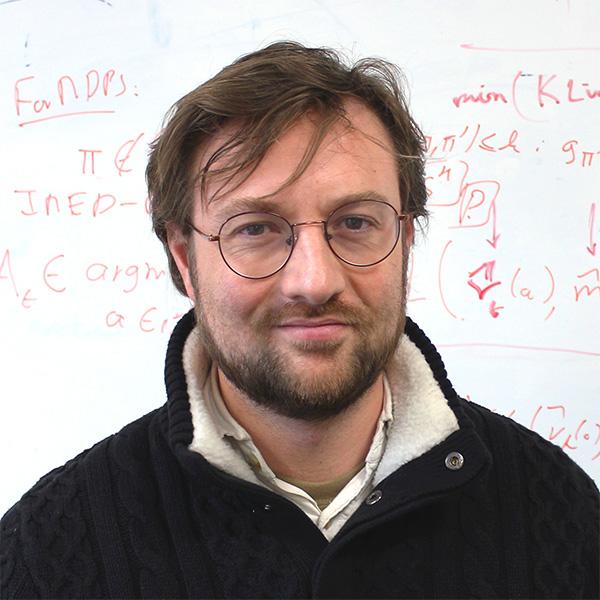

Image

Verbatim

Nous avons confronté nos algorithmes à des simulateurs utilisés pour la prédiction de paramètres tels que le rendement, la fertilité du sol, ou la qualité de la récolte. Nos méthodes basées sur les bandits ont donné de meilleurs résultats que les expérimentations habituelles des agronomes.

Auteur

Poste

Chargé de recherche Inria

Ces travaux ont débouché sur des algorithmes de bandits manchots optimaux dans un cadre non paramétrique. Une première !

Le respect de la vie privée représente un autre défi, en particulier en médecine. Lors de leur apprentissage, les algorithmes risquent de mettre en évidence des variables pouvant contribuer à identifier des patientes et patients. Instaurer le respect de la confidentialité impose donc une contrainte en plus au problème, et modifie les performances des algorithmes. Grâce à ces nouvelles recherches, les scientifiques sont désormais en capacité de prévoir les performances théoriques atteignables avec cette contrainte, et ainsi de déterminer quel est le meilleur algorithme.

Une dernière difficulté a été étudiée : alors que les données issues de la simulation restent "propres", celles tirées de cas réels peuvent être "corrompues". En clair, il n’est pas rare de rencontrer des valeurs aberrantes, par exemple quand le diabète d’un patient ou une patiente perturbe le résultat d’un traitement, ou quand l’arrivée d’une espèce invasive affecte la qualité des récoltes. Les résultats obtenus par Reliant ont permis d’avancer sur la compréhension de ces cas de figure, en vue de transformer les algorithmes et de les rendre plus robustes.

« Les travaux menés dans le cadre de Reliant nous ont beaucoup appris sur l’importance de ces différents facteurs dans les problèmes de bandits manchots, résume Junya Honda. Grâce à ce partenariat, la recherche sur le domaine applicatif des algorithmes a véritablement avancé. » En effet, ces trois années d’équipe associée ont été prolifiques, comme en témoignent les nombreuses publications rédigées par les six chercheurs permanents de Reliant et leurs étudiantes et étudiants.

Tous ces résultats ouvrent de nouvelles perspectives : « À mesure que l’on confronte les bandits manchots à la réalité, de nouvelles questions apparaissent, conclut Odalric-Ambrym Maillard. Actuellement, nous avons identifié une vingtaine de challenges et travaillons à leur résolution. Et ce n’est sans doute pas fini ! »

Le programme "équipe associée" s’inscrit dans le cadre de la politique internationale d’Inria. Ses objectifs : soutenir des collaborations scientifiques bilatérales, et promouvoir et renforcer des partenariats stratégiques d’Inria à l’étranger. Financée durant trois ans, une équipe associée porte un projet de recherche commun entre une équipe-projet Inria et une équipe de recherche à l'étranger.

Les deux partenaires définissent conjointement un objectif scientifique, un plan de recherche et un planning d’échanges bilatéraux d’étudiants. « Il est important pour les doctorantes et doctorants de découvrir différents environnements de recherche », argumente Odalric-Ambrym Maillard, chargé de recherche Inria. « Plus généralement, rencontrer ses homologues crée une synergie, et facilite l’émergence de nouveaux projets. »

L’équipe associée Reliant s’est avérée fructueuse : « Nos deux entités réunissaient déjà les expertes et experts de niveau mondial sur les sujets de l’apprentissage par renforcement et des bandits manchots. En regroupant nos expertises complémentaires, nos recherches respectives se sont considérablement accélérées », retrace le chercheur français. Junya Honda, professeur associé à l’université de Kyoto, complète : « Ensemble, nous avons trouvé comment combler l’écart entre les performances théoriques et réelles des algorithmes de bandits manchots. C’est très innovant ! »

Les travaux communs et les discussions scientifiques au sein de Reliant ont permis de concevoir des outils applicables par chaque équipe dans son pays. Et les domaines d’application sont très variés : l’amélioration des récoltes en adaptant les cultures à l’environnement, les essais cliniques, où le but est de doser un médicament en tenant compte des effets secondaires, ou encore l’identification de cellules cancéreuses au microscope avec le moins de mesures possible.