Vers une nouvelle génération de modèles océanographiques

Date:

Mis à jour le 30/10/2024

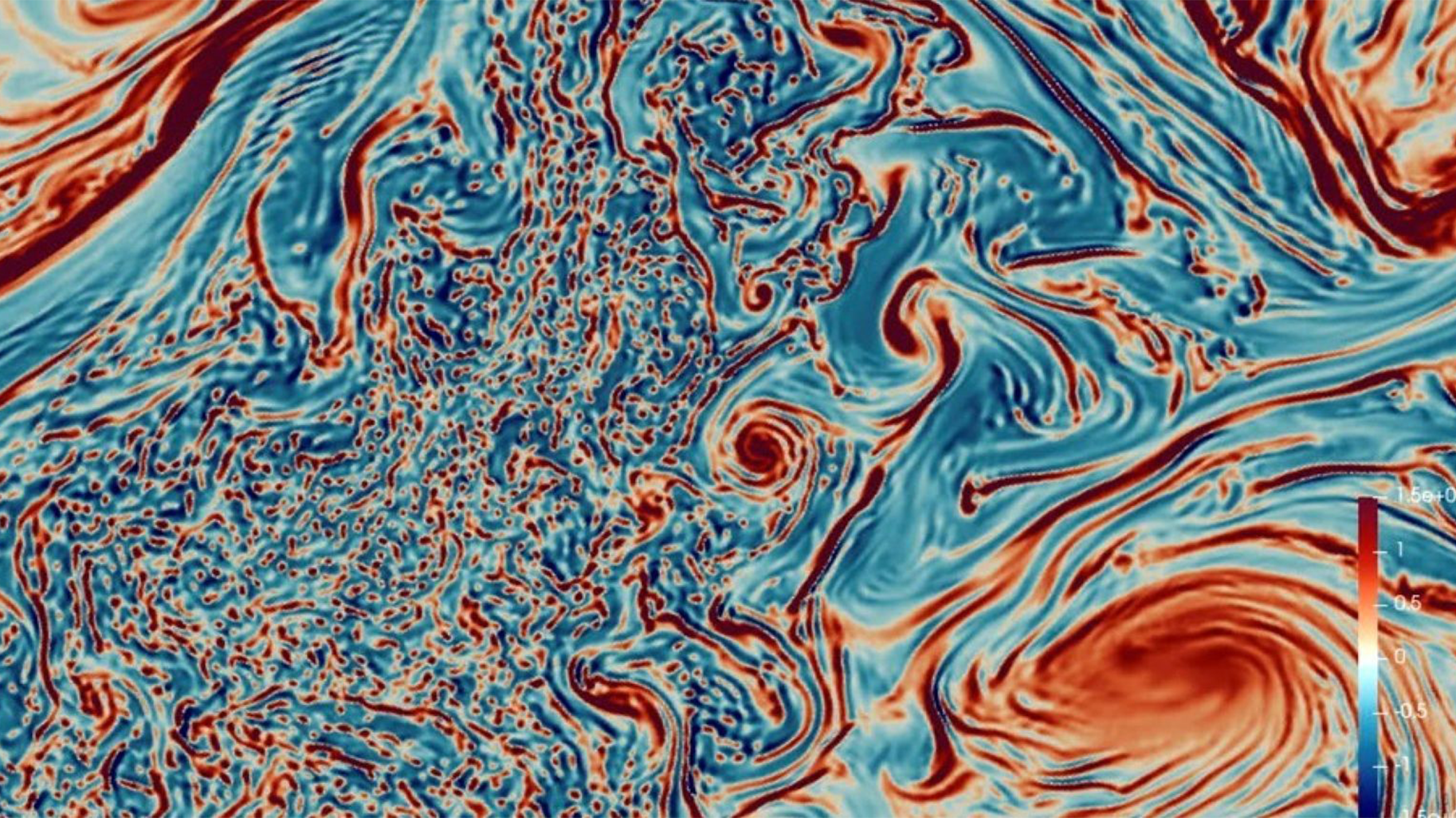

En recyclant le gaz carbonique et en absorbant la chaleur, les océans jouent un rôle clé dans la régulation du climat. Mais eux-mêmes se réchauffent. Plus 1,5 °C depuis le début de l’ère industrielle… L’essentiel de cette énergie supplémentaire s’entrepose près de la surface, à une profondeur allant de zéro à 700 m. Pour mieux appréhender le dérèglement provoqué par l’effet de serre, la modélisation des couches océaniques supérieures revêt donc une importance particulière.

Toutefois, les modèles océaniques actuels souffrent d’une limite. S’ils sont basés sur de la physique causale et répondent à un certain déterminisme, ils s’avèrent aussi de nature chaotique. Ce qui les rend très sensibles aux conditions d’origine. De petites variations de ces conditions initiales dans le modèle peuvent suffire à engendrer des résultats différents. Et cela en relativement peu de temps. Conséquence : de l'incertitude subsiste.

C’est pour imaginer une solution à ce problème scientifique que le Conseil européen de la recherche (ERC) finance actuellement le projet Stuod autour duquel se retrouvent les scientifiques Dan Crisan, Darryl Holm (Imperial College London), Bertrand Chapron (Ifremer) et Étienne Mémin (Inria). Les travaux courent sur six ans, jusqu’en 2026. Le budget atteint 10 millions d’euros attribués dans le cadre de Synergy, un programme ERC qui encourage les recherches exploratoires à caractère pluridisciplinaire.

Image

Verbatim

Nous pensons pouvoir proposer des modèles de déplacements de fluides océaniques possédant en leur sein la capacité de gérer les incertitudes du modèle. C’est-à-dire de quantifier toutes les approximations qui sont faites dans ce modèle et d’avoir une idée de leur évolution dans le temps.

Auteur

Poste

Directeur de recherche et responsable de l'équipe-projet Odyssey

D’une façon générale, “tous les modèles résultent d’approximations. D’abord parce qu’ils négligent des processus de petite échelle. Ensuite, les schémas numériques sont eux-mêmes des approximations d’opérateurs continus que l’on ne peut évidemment pas mettre en œuvre sur un ordinateur. On est obligé de discrétiser les choses pour la machine. Par exemple, on ne peut pas manipuler une dérivée partielle. Il faut la discrétiser. On génère donc des approximations numériques. Il y a aussi le problème lié au coût de calcul. La façon la plus simple de le réduire, c’est d’abaisser la résolution. Mais quand on fait cela, on est confronté à des approximations violentes sur les systèmes que l’on souhaite modéliser.”

Quant à l’incertitude générée par toutes ces approximations, “elle va évoluer dans le temps et il faut la caractériser. La meilleure façon, c’est de la prendre en compte directement dans le modèle. Donc construire des modèles qui vont inclure une représentation de cette incertitude et de sa dynamique.” Pour ce faire, le projet Stuod ambitionne de “passer d’une physique causale déterministe à une représentation aléatoire, stochastique, de cette physique.” Concrètement donc, une distribution de probabilités va donc venir quantifier l’incertitude.

Au passage, ces méthodes offrent également un degré de liberté supplémentaire. “Par rapport au modèle déterministe, on peut avoir quelque chose de très proche et puis ensuite proposer des modèles qui vont relâcher progressivement des lois d’équilibres sur lesquelles sont bâties certaines approximations. On produit ainsi une variété de sous-modèles un peu intermédiaires entre deux modèles déterministes qui, eux, demeurent complètement séparés. Un tel continuum de représentations me paraît souhaitable quand on veut traiter des applications assez différentes les unes des autres. Quand on veut étudier des phénomènes très spécifiques dans la dynamique océanique, on ne va pas s’y prendre avec les mêmes outils, avec les mêmes modèles. On change de lunettes.”

En pratique, les recherches s’appuient sur deux approches. Inria porte un modèle stochastique général dit "newtonien" applicable à tous les écoulements fluides. Imperial College London porte un modèle dit "hamiltonien" dont l’usage est plus restreint. Stuod vise à analyser leurs propriétés mathématiques respectives et à construire des modèles océanographiques à partir de ces deux cadres méthodologiques rigoureux.

“Nous sommes partis de modèles idéalisés pour aller vers des modèles réalistes intégrant ces schémas stochastiques. Nous arrivons à des résultats assez remarquables. Nous devrions pouvoir parvenir à un démonstrateur qui vise à inclure ce cadre stochastique dans un modèle opérationnel océanographique dans les deux ans qui viennent.”

Créée en 2022, implantée à Rennes et Brest, l’équipe commune Odyssey rassemble six entités académiques françaises : Ifremer, IMT Atlantique, Université de Bretagne Occidentale, Université de Rennes, CNRS et Inria. À sa tête : Étienne Mémin. “Nous sommes 21 chercheurs permanents. Le groupe comprend à la fois des gens proches des modèles, du couplage entre les observations et ces modèles, des physiciens qui visent à l’analyse de certains phénomènes impliqués dans la dynamique océanique, mais aussi des mathématiciens qui s’intéressent à l’analyse mathématique de ces modèles.”

Depuis quelques années, l’intelligence artificielle s’invite également dans ces recherches. “Dans l’équipe, beaucoup travaillent sur le Machine Learning. Chacun avec ses différences. Certains sont plus proches des modèles. D’autres s’intéressent davantage aux données. Ces méthodes d’apprentissage automatique vont servir soit à des fins d’analyse de données soit à des fins de paramétrisation de processus complexes dans les simulations numériques. Voire, dans le cas le plus extrême, à complètement définir le modèle dynamique par les données. Dans ce cas-là, on injecte très peu de physique. On a une multitude d’exemples. Et à partir de tous ces exemples, on essaye d’inférer une dynamique des processus que l’on veut observer.”

Jusqu’à présent, l’équipe est plutôt focalisée sur l’océan. “Mais il y a une autre composante : l’atmosphère. Or, cette interaction océan-atmosphère s’avère fondamentale dans les modèles de climat. Donc, nous aimerions aller dans cette direction. L’idée serait d’élaborer pour l’océan et l’atmosphère un cœur dynamique physique dans le cadre d’une modélisation stochastique. Puis d’avoir des parties conduites par du Machine Learning pour les phénomènes physiques les plus complexes dans l’océan ou l’atmosphère. Par exemple, la convection, la mer de glace dans l’océan, le couplage entre les vagues et le courant… C’est donc ce nouveau triptyque modélisation stochastique numérique / analyse mathématique / IA qui serait au centre du projet que j’aimerais porter ensuite.”

Titre

Visuel

Titre du lecteur

En savoir plus sur la nouvelle génération de modèles océanographiques

Fichier audio

Audio file

Je suis Etienne Mémin. Je suis directeur de recherche à Inria et je dirige l'équipe Odyssey qui est une équipe jointe entre six instituts : le CNRS, deux universités, l'Université de Bretagne Occidentale à Brest, l'Université de Rennes, INRIA, l'IMT Atlantique et Ifremer. Donc c'est une équipe qui est composée de 21 chercheurs permanents et qui est localisée entre Rennes et Brest. Le centre d'intérêt de l'équipe, c'est la dynamique océanique et dans ce cadre, on va s'intéresser à des problèmes qui vont de problèmes d'analyse de données, de collecte de données sur la dynamique océanique jusqu'à la modélisation stochastique ou déterministe de l'Océan, de la dynamique océanique, en passant par des problèmes de machine learning pour caractériser ou à des fins d'analyse soit à des fins de modélisation, donc des processus physiques dans la dynamique océanique.

Les modèles ils sont essentiels en fait pour deux choses. Ils sont essentiels évidemment pour des problèmes de prévision, soit à court terme, peut être la journée, plusieurs jours, plusieurs semaines, etc. Soit à très long terme pour des problématiques climatiques où là l'océan, évidemment, il y a une importance primordiale. Certains océanographes sont très contents des modèles. Ceux qui sont investis dans la définition de ces modèles sont plutôt contents de leur modèle. Maintenant, les gens qui sont plus proches des données voient peut être un peu plus la différence qu'il peut y avoir entre la réalité et un modèle physique, et donc du coup, perçoivent qu'il y a encore beaucoup, beaucoup de choses à améliorer.

Je pense que à peu près tout le monde s'accorde à dire que pour le moment, les modèles ne savent pas traiter les incertitudes et c'est l'objet principal de mon travail. Ces incertitudes et leur dynamique, en fait, jouent un rôle prépondérant quand on veut chercher à simuler des réalisations plausibles de l'état de l'océan. L'équipe Odyssée a un très grand avantage, c'est de rassembler des gens qui sont à la fois proches des modèles, des observations, du couplage entre ces observations et ces modèles, ou des physiciens qui visent à l'analyse physique de certains phénomènes impliqués dans la dynamique océanique.

Il y a aussi également des mathématiciens dans Odyssey qui donc eux, ont plutôt un intérêt qui se porte sur l'analyse mathématique de ces modèles. Quand on parle de modèle stochastique par exemple, cette analyse est d'autant plus difficile parce qu'on met avec des outils qui sont moins courants, plus difficiles à aborder. On introduit de l'aléatoire dans la modélisation, on vise à passer d'une physique causale déterministe à une représentation aléatoire, stochastique de cette physique, et en particulier de son aspect dynamique.

Ce qu'on pense pouvoir proposer, ce sont des modèles qui justement ont la capacité d'avoir en leur sein la gestion des incertitudes du modèle, c'est à dire une quantification de toutes les approximations qui sont faites dans le modèle et d'avoir une image, une idée de leur évolution dans le temps. L'ERC STUOD c'est une ERC collaborative qui joint Ifremer, Inria, Imperial College et qui a pour objet d'intérêt des modèles stochastiques pour la dynamique océanique.

Inria apporte un modèle stochastique général qui est applicable à tous les écoulements fluides. Imperial College s'intéresse à un modèle qui lui est restreint, en fait au modèle hamiltonien. L'ERC STUOD vise à analyser les propriétés mathématiques de ces deux types de modèles et à construire, dériver des modèles océaniques à partir de ces deux grands cadres méthodologiques et visent à les appliquer à la dynamique océanique avec in fine pour but le fait de de bâtir notamment des techniques d'assimilation de données, c'est à dire de couplage entre modèle et données, où là, l'incertitude, l'aspect aléatoire des modèles joue un rôle primordial dans les méthodes de ce type. On devrait pouvoir arriver à un démonstrateur final qui vise à inclure ce cadre stochastique dans un modèle opérationnel.